Franz Lenbach pinx. Franz Hanfstaengl ed.

Title: Die Naturwissenschaften in ihrer Entwicklung und in ihrem Zusammenhange, IV. Band

Author: Friedrich Dannemann

Release date: May 13, 2019 [eBook #59493]

Language: German

Credits: Produced by Peter Becker, Heike Leichsenring and the Online

Distributed Proofreading Team at http://www.pgdp.net

DARGESTELLT VON

FRIEDRICH DANNEMANN

VIERTER BAND:

DAS EMPORBLÜHEN DER MODERNEN NATURWISSENSCHAFTEN

SEIT DER ENTDECKUNG DES ENERGIEPRINZIPS

MIT 70 ABBILDUNGEN IM TEXT UND MIT

EINEM BILDNIS VON HELMHOLTZ

LEIPZIG UND BERLIN

VERLAG VON WILHELM ENGELMANN

1913

Copyright 1913 by Wilhelm Engelmann, Leipzig.

Druck der Königl. Universitätsdruckerei H. Stürtz A. G., Würzburg.

Franz Lenbach pinx. Franz Hanfstaengl ed.

Mit dem vorliegenden, vierten Bande kommt das Unternehmen, die Naturwissenschaften in ihrer Entwicklung und in ihrem Zusammenhange darzustellen, zum Abschluß. Der erste Band führte von den Anfängen bis zum Wiederaufleben der Wissenschaften, der zweite von Galilei bis etwa zur Mitte des 18. Jahrhunderts. Zwischen dem 3. und dem jetzt erscheinenden 4. Bande ließ sich keine scharfe chronologische Schranke ziehen. Beide Bände schildern in der Hauptsache das Emporblühen der modernen Naturwissenschaften, das mit der Wende vom 18. zum 19. Jahrhundert anhebt. Einen gewissen Abschnitt bildet die Aufstellung des Energieprinzips. Die Entdeckung dieses, die moderne Wissenschaft beherrschenden Prinzips war aber keine unvermittelte. Sie wurde durch das Auffinden zahlreicher Tatsachen und Beziehungen allmählich vorbereitet. Infolgedessen tritt das neue Prinzip in den ersten Abschnitten des vierten Bandes erst nach und nach immer deutlicher in die Erscheinung, bis es gegen die Mitte des 19. Jahrhunderts zu einem klaren Ausdruck und seitdem zur bewußten Ausdehnung auf sämtliche Naturwissenschaften gelangt. Gleichzeitig erfolgt auf dem Gebiete der organischen Wissenschaften das Emporkeimen des Entwicklungsgedankens. Wir stehen noch heute inmitten des Ringens, das an der Hand dieser umfassenden, dem 19. Jahrhundert sein Gepräge verleihenden Prinzipien zu immer größerer Klarheit führen wird. Es mußte daher das Ziel des letzten Bandes sein, den Wegen nachzugehen, die von dem älteren, gesicherten Bestande zu den Problemen des Tages hinüberführen. Als Marksteine auf diesen Wegen begegnen uns die Originalarbeiten der großen Forscher. Diese Arbeiten sind durch Ostwalds umfangreiches Unternehmen der »Klassiker der exakten Wissenschaften« weiteren Kreisen zugänglicher geworden. Der Aufgabe, für dieses Unternehmen gewissermaßen einen Rahmen zu schaffen, ist sich der Verfasser auch in dem vorliegenden Bande stets bewußt geblieben.

Nur unter Beachtung der erwähnten Gesichtspunkte war es möglich, den immer mehr anschwellenden Stoff zu bewältigen und die Darstellung zu einem hoffentlich glücklichen Abschluß zu führen. Da die Beschränkung auf das Wichtigste und das Allgemeine für den letzten Band noch mehr geboten schien als für die drei übrigen, so darf man das nunmehr vollendete Werk nicht als ein Nachschlagebuch betrachten und es gar unbefriedigt aus der Hand legen, wenn es über dieses oder jenes Einzelwissen keine Auskunft gibt. Trotzdem wurde auf ein ausführliches Namen-, Sach- und Literaturverzeichnis nicht verzichtet, da es immerhin erwünscht ist, die Zusammengehörigkeit der im Text getrennten Angaben rasch auffinden zu können.

Hoffentlich ist es gelungen, ein Werk zu schaffen, das die Beziehungen der Naturwissenschaften unter sich und zu den Nachbargebieten im Rahmen der Gesamtentwicklung aufweist und das den weitesten Kreisen der Forschenden, der Lehrenden und Lernenden dasjenige bringt, was zu einem tieferen Verständnis des heutigen Wissenschaftsgebäudes nötig ist. Auch solchen, die ihre Aufgabe in der Anwendung der Wissenschaften erblicken, wie den Ärzten und den Technikern, dürfte das Gebotene willkommen sein, um so mehr, als auf wichtige Anwendungen der Wissenschaft an vielen Stellen Bezug genommen ist. Was die Wissenschaftsgeschichte für die Gegenwart bedeutet, wird zu Beginn des ersten Abschnittes geschildert. In seinem zweiten Teile wird dann der Faden der zusammenhängenden Darstellung wieder aufgenommen.

Friedrich Dannemann.

1. Wissenschaft und Wissenschaftsgeschichte.

1. Einleitendes. – 2. Einzeldarstellungen und Schilderung der Gesamtentwicklung. – 3. Förderung der Wissenschaftsgeschichte. – 4. Vorlesungen über Wissenschaftsgeschichte. – 6. Wert des geschichtlichen Studiums. – 8. Geschichte der Medizin und der Technik. – 9. Anfänge der Wissenschaft. – 10. Rückblick auf das Altertum. – 12. Das Weltbild im Altertum. – 13. Das Experiment im Altertum. – 14. Naturwissenschaft und Philosophie. – 15. Rückblick auf das Mittelalter. – 16. Das arabische Zeitalter. – 17. Das Wiederaufleben der Wissenschaften. – 19. Das Zeitalter Galileis. – 21. Newtons Zeitalter. – 23. Astronomie der Fixsterne – 25. Einheitliche Auffassung der Natur.

2. Die Astronomie nach ihrer Begründung als Mechanik des Himmels.

27. Die Entdeckung des Uranus. – 29. Die Parallaxe der Fixsterne. – 32. Die Länge des Sekundenpendels. – 34. Enckes Komet. – 35. Himmelskarten. – 36. Sonnenparallaxe. – 37. Bahnberechnungen.

3. Die älteren Zweige der Physik bis zu ihrem Eintritt in das Zeitalter des Energieprinzips.

38. Die Entdeckung der Osmose. – 40. Die Entdeckung der Diffusion. – 42. Trennung durch Dialyse. – 43. Kolloide und Kristalloide. – 44. Osmotische Vorgänge. – 45. Ausdehnungskoeffizient der Gase. – 46. Rudbergs Nachprüfung. – 47. Versuche von Magnus und Regnault. – 48. Die Natur des gasförmigen Zustandes. – 50. Kritische Temperatur. – 51. Permanente Gase. – 52. Zustandsgleichung. – 53. Avogadros Regel. – 55. Dampfdichtebestimmung. – 57. Theoretische Optik. – 58. Dopplers Prinzip. – 60. Polaristrobometer. – 61. Stereoskop. – 63. Schlierenapparat. – 65. Lichtgeschwindigkeit. – 67. Emission oder Undulation. – 68. Licht und Wärme.

4. Die Begründung der neueren Elektrizitätslehre.

69. Faraday. – 71. Elektrizität und Magnetismus. – 72. Die Entdeckung der Induktion. – 74. Aragos Versuch. – 76. Wärmewirkung der Induktionsströme. – 77. Induzierende Wirkung des Erdmagnetismus. – 79. Die Ent[Pg vi]deckung des Extrastromes. – 82. Entladung durch Gase. – 84. Elektrizitätsarten. – 85. Chemische Wirkungen der Elektrizität. – 86. Magnetelektrische Maschine. – 87. Voltaelektrometer. – 88. Elektrolytisches Grundgesetz. – 90. Bekämpfung der Kontakttheorie. – 91. Chemische Theorie des Stromes. – 92. Magnetisierung des Lichtes. – 94. Diamagnetismus. – Diëlektrikum. – 96. Theorie der Elektrizität. – 97. Das Biot-Savartsche Gesetz. – 98. Ampères elektrodynamisches Grundgesetz. – 99. Georg Simon Ohm. – 100. Das Ohmsche Gesetz. – 102. Wärmewirkung des Stromes. – 103. Das Joulesche Gesetz. – 104. Thermoströme. – 105. Peltiers Phänomen. – 106. Stärke der Induktionsströme. – 107. Lenzsches Grundgesetz. – 108. Franz Ernst Neumann. – 109. Die Theorie induzierter Ströme. – 110. Webers elektrodynamisches Grundgesetz. – 111. Die Theorie der Induktion. – 112. Webers Tangentenbussole. – 113. Elektrochemisches Äquivalent. – 115. Elektrodynamometer. – 116. Einheit der Elektrizität.

5. Die Begründung der organischen Chemie und ihr Einfluß auf die Entwicklung der chemischen Vorstellungen.

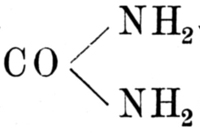

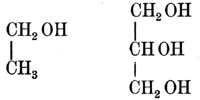

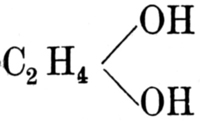

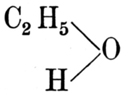

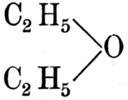

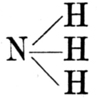

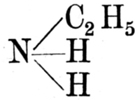

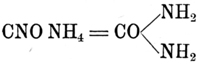

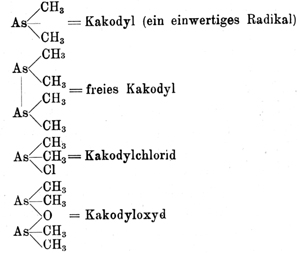

118. Einleitendes. – 119. Radikale. – 120. Radikaltheorie. – 122. Liebig. – 124. Chemische Laboratorien. – 125. Wöhler. – 126. Isomerie. – 127. Synthese organischer Verbindungen. – 128. Säuren und Salze. – 129. Basizität der Säuren.– 130. Benzol. – 131. Benzolderivate. – 132. Organische Säuren. – 133. Bunsen. – 134. Das Radikal Kakodyl. – 136. Organische und unorganische Chemie. – 137. Alkohole und Säuren. – 138. Radikale und Typen. – 139. Begründung der Typentheorie. – 140. Einzelne Typen. – 141. Doppeltypen. – 142. Gemischte Typen. – 143. Äquivalent, Atom, Molekül. – 144. Anfänge der Strukturtheorie.

6. Die Begründung der Physiologie als eines besonderen Wissenszweiges.

146. Einleitendes. – 147. Physiologie und Bodenkunde. – 148. Chemie und Physiologie. – 149. Naturwissenschaft und Medizin. – 150. Naturwissenschaft und Philosophie. – 151. Physiologie und Anatomie. – 152. Physiologie der Sinnesorgane. – 154. Erschütterung der Lehre von der Lebenskraft.

7. Die Zelle wird als das Grundorgan der pflanzlichen und tierischen Organismen erkannt.

155. Erneuerung der Pflanzenanatomie. – 156. Fortschritte der Mikroskopie. – 157. Tier- und Pflanzenzellen. – 158. Elementarorganismen. – 159. Die Zusammensetzung der Zellen. – 160. Der Organismus, ein Zellenstaat. – 161. Zellularpathologie. – 162. Die Entstehung der Zellen. – 163. Die Natur des Protoplasmas. – 164. Wachstum und Werden der Zellen. – 165. Entwicklung und Morphologie der Gewebe. – 166. Das Gefüge der organisierten Substanz.

8. Die Geologie im Zeitalter des Aktualismus und in engerer Verknüpfung mit den übrigen Naturwissenschaften.

167. Abkehr von der Katastrophentheorie. – 169. Die Zeit als geologischer Faktor. – 171. Geologie und Biologie. – 172. Das Leben als geologischer Faktor. – 173. Ehrenbergs Mikrogeologie. – 174. Korallen und Korallenriffe. – 175. Gebirgsbildung. – 176. Tiefseeforschungen.

9. Die Ausdehnung des Energieprinzips auf sämtliche Naturwissenschaften.

177. Das Prinzip vom ausgeschlossenen Perpetuum mobile. – 178. Der Zusammenhang der Kräfte. – 179. Robert Mayer. – 180. Wärme und Arbeit. – 181. Das mechanische Äquivalent der Wärme. – 182. Die Äquivalenz sämtlicher Naturkräfte. – 183. Das Wesen der Kräfte. – 185. Physik und Biologie. – 186. Joule. – 187. Die Bestimmung des Wärmeäquivalents. – 189. Colding. – 190. Helmholtz. – 191. Lebendige Kraft und Spannkraft. – 192. Das Prinzip von der Erhaltung der Kraft. – 194. Der Kraftvorrat des Sonnensystems. – 195. Mechanische Wärmetheorie. – 196. Hauptsätze der mechanischen Wärmetheorie. – 198. Die kinetische Gastheorie. – 200. Die Thermodynamik der Lösungen.

10. Neuere Fortschritte in der Erforschung des organischen Lebens.

201. Biologie der Mikroorganismen. – 204. Die Erreger der Gärung und der Fäulnis. – 205. Fortpflanzung durch Schwärmsporen. – 206. Sexualität der Kryptogamen. – 207. Verwandtschaftliche Zusammenhänge. – 208. Erklärung der Lebenserscheinungen. – 209. Anatomie und Physiologie. – 210. Aufbau der Gewebe. – 211. Die Reizbarkeit. – 212. Richtungsbewegungen. – 213. Mechanik der Bewegungen. – 214. Mechanik des Saftsteigens. – 216. Organisation des Protoplasmas. – 217. Physik und Physiologie. – 218. Puls- und Wellenlehre. – 220. Mechanik der Sekretionsvorgänge. – 222. Messung des Sekretionsdruckes. – 223. Physiologie und graphisches Verfahren. – 224. Die Erklärung des Farbenwechsels. – 225. Interferenz und Pigmente. – 226. Reflextätigkeit. – 227. Chromatische Funktion. – 228. Physiologie des Gesichtssinnes. – 229. Entoptische Erscheinungen. – 230. Physiologie und Psychologie. – 231. Experimentelle Grundlagen der Psychologie. – 233. Das psychophysische Grundgesetz. – 234. Individuelles und phylogenetisches Gedächtnis. – 235. Nerventätigkeit. – 236. Lehre von der Lebenskraft. – 237. Verwandtschaft und Entwicklung. – 238. Parthenogenese. – 239. Generationswechsel. – 241. Tier- und Pflanzenleben.

11. Die wissenschaftliche Begründung der Entwicklungslehre.

243. Organismus und Umwelt. – 244. Umbildung durch Anpassung. – 245. Aussterben und Entstehen von Arten. – 246. Entwicklungsgeschichtliche [Pg viii]Methode. – 247. Verwandtschaftliche Beziehungen. – 248. Morphologie und Embryologie. – 249. Gemeinsame Urform. – 250. Die Bedeutung der Übergangsformen. – 251. Charles Darwin. – 252. Mechanisch wirkende Ursachen. – 253. Die Malthussche Lehre. – 254. Natürliche Zuchtwahl. – 255. Beweismittel der Deszendenztheorie. – 256. Unzulänglichkeit der Darwinschen Theorie. – 257. Abstammung des Menschen. – 258. Biogenetisches Grundgesetz. – 259. Entwicklungsmechanik. – 260. Bastardbildung. – 262. Mendels Versuche. – 263. Dominierende und rezessive Merkmale. – 264. Mendelsche Regeln. – 266. Mendelismus.

12. Geologie und Mineralogie unter dem Einfluß der chemisch-physikalischen Forschung.

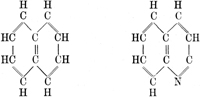

268. Mikroskopie und Gesteinskunde. – 269. Ergebnisse der Gesteinsmikroskopie. – 270. Geologische Experimente. – 271. Gebirgsbildung. – 272. Erdbebenforschung. – 273. Das Leben als geologischer Faktor. – 274. Mikrogeologische Studien. – 275. Gletscher und Moränen. – 276. Das Eis als geologischer Faktor. – 277. Die Lehre von den Eiszeiten. – 278. Gestalt und Masse der Erde. – 279. Form und Eigenschaften der Mineralien. – 280. Ableitung der Kristallsysteme. – 282. Kristallographie und Mathematik. – 283. Kristallographie und Physik. – 284. Die Entstehung der Mineralien.

13. Die Entwicklung der Strukturchemie und der Systematik der chemischen Elemente.

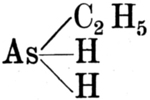

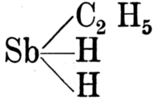

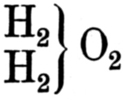

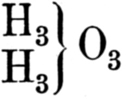

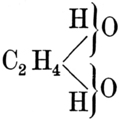

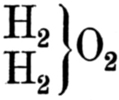

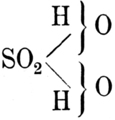

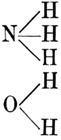

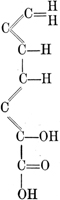

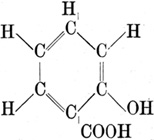

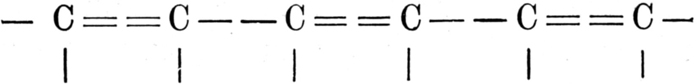

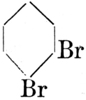

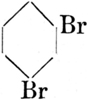

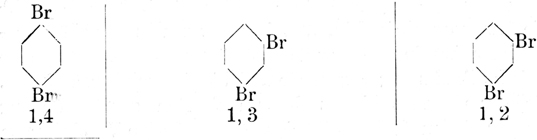

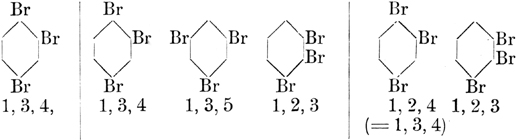

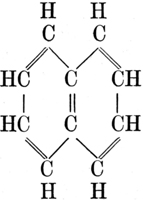

286. Valenztheorie und Strukturchemie. – 287. Atomverkettung. – 288. Strukturformeln. – 289. Aromatische Verbindungen. – 290. Benzoltheorie. – 292. Bestimmung des chemischen Ortes. – 294. Erweiterung der Benzoltheorie. – 295. Fortschritte der Synthese. – 296. Physikalische Isomerie. – 297. Symmetrischer und asymmetrischer Aufbau. – 298. Die Anfänge der Stereochemie. – 299. Döbereiners Triaden. – 301. Versuch einer Gruppierung sämtlicher Elemente. – 302. Nachprüfung der Atomgewichte. – 303. Das periodische System. – 306. Vorhersage der Existenz des Germaniums.

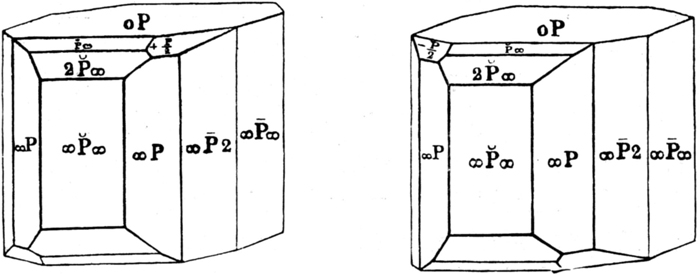

14. In der Spektralanalyse und in der Photographie entstehen die wichtigsten neuzeitlichen Forschungsmittel.

309. Anfänge der Spektralanalyse. – 310. Die Entdeckung der Fraunhoferschen Linien. – 312. Bunsen und Kirchhoff erfinden das Spektroskop. – 313. Die Spektren der Metalle. – 314. Die Empfindlichkeit der Spektralreaktion. – 316. Die Umkehrung der Spektren. – 317. Emission und Absorption. – 318. Die spektralanalytische Untersuchung der Sonne. – 320. Die Entdeckung neuer Elemente. – 322. Verbesserungen des Spektroskops. – 323. Anwendungen der Spektralanalyse. – 324. Spektroskopie und Astronomie. – 325. Anfänge der Photographie. – 327. Photographie und Astronomie. – 328. Farbenphotographie.

15. Das Emporblühen der physikalischen Chemie.

330. Physikalische und chemische Eigenschaften. – 331. Photochemische Messungen. – 334. Photochemische Induktion. – 335. Photochemie und Astronomie. – 336. Photochemische Wirkungen des Spektrums. – 337. Polarisiertes Licht und chemische Zusammensetzung. – 338. Polarisation und kristallinisches Gefüge. – 339. Chemisch-optische Untersuchungen. – 342. Drehungsvermögen und chemisches Gleichgewicht. – 345. Dynamisches oder statisches Gleichgewicht. – 346. Affinität und Wärmetönung. – 347. Grundgesetz der Thermochemie. – 349. Abnorme Dampfdichten. – 350. Theorie der Dissoziation. – 352. Thermodynamische Untersuchungen. – 353. Massenwirkungsgesetz. – 354. Reaktionsgeschwindigkeit. – 356. Geschwindigkeitskoeffizient. – 357. Reaktionsverlauf. – 358. Bedingungen des Gleichgewichtszustandes. – 359. Mechanik der chemischen Vorgänge. – 360. Grundgesetze der chemischen Mechanik. – 362. Osmotische Untersuchungen. – 363. Ähnlichkeit des gasförmigen und des gelösten Zustandes. – 364. Osmotischer Druck und absolute Temperatur. – 365. Ausdehnung der Gasgesetze auf Lösungen. – 366. Dissoziation in Lösungen. – 367. Theorie der elektrolytischen Dissoziation. – 368. Der Vorgang der Elektrolyse. – 370. Die Wanderung der Ionen. – 371. Leitfähigkeit der Elektrolyte.

16. Neuere Fortschritte der theoretischen und der angewandten Physik.

373. Fortschritte der mathematischen Physik. – 374. Fortschritte der Akustik. – 375. Analyse des Klanges. – 376. Fortschritte der Optik. – 377. Physiologie und Optik. – 378. Physiologie und Psychophysik. – 379. Fortschritte der Elektrizitätslehre. – 380. Elektrische Schwingungen. – 382. Die Versuche von Hertz. – 383. Elektrische Strahlen. – 384. Licht und Elektrizität. – 385. Funkentelegraphie. – 386. Faradays Kraftlinien. – 387. Maxwellsche Theorie. – 388. Elektromagnetische Theorie des Lichtes. – 389. Elektronentheorie. – 390. Theorie der galvanischen Elemente.

17. Die Naturwissenschaften und die moderne Kultur.

392. Die Grundlagen der chemischen Industrie. – 393. Chemische Industrie und Leuchtgaserzeugung. – 394. Neue Herstellungsweisen. – 396. Die organisch-chemische Industrie. – 397. Wichtige Synthesen. – 398. Technik und Physik. – 399. Telegraphie und Telephonie. – 400. Galvanoplastik. – 401. Elektrisches Licht. – 402. Elektrizitätsquellen. – 403. Dynamoelektrisches Prinzip. – 404. Elektrotechnik und Chemie. – 405. Neue wirtschaftliche Probleme. – 407. Wissenschaft und Produktion. – 408. Materielle und geistige Kultur. – 409. Naturwissenschaft und Erkenntnistheorie. – 410. Naturwissenschaft und Geisteswissenschaften. – 411. Ethische Bedeutung der Naturwissenschaften. – 412. Grenzen der Naturwissenschaften. – 413. Ausgestaltung des Weltbildes.

18. Aufgaben und Ziele.

415. Fortschritte der Methode. – 416. Forschungsinstitute. – 417. Tiefe und hohe Temperaturen. – 419. Verknüpfung der Wissenschaftsgebiete. – 421. Neue physikalische Gebiete. – 422. Die Entdeckung der Radioaktivität. – 423. Neue Strahlengattungen. – 424. Elektronentheorie. – 426. Fortschritte der Methoden. – 427. Fortschritte der Photographie und Mikroskopie. – 429. Fortschritte der Astronomie. – 430. Astronomische Probleme. – 431. Probleme der Biologie. – 433. Schlußwort.

| Namenverzeichnis für Band I-IV | S. 434 |

| Sachverzeichnis für Band I-IV | S. 453 |

| Literaturverzeichnis für Band I-IV | S. 470 |

| Verzeichnis der Abbildungen für Band IV | S. 506 |

Von keinem Gegenstand im gesamten Bereich unserer Erfahrung besitzen wir einen klaren Begriff, wenn wir uns nicht seine Entwicklung vergegenwärtigen können. Am längsten gilt dieser Satz für das Verständnis der Staatengebilde. Für alles, was den Menschen als Staatsbürger angeht, hat daher stets die Geschichte als die große Lehrmeisterin gegolten. Auch die heutige Naturwissenschaft steht unter dem Einfluß des Entwicklungsgedankens. Dieser Gedanke hat im Laufe des 19. Jahrhunderts alle Gebiete erobert, besonders, seitdem es gelungen ist, die allmähliche Entwicklung der Tier- und Pflanzenwelt begreiflich zu machen. Sonderbarerweise hat man die Wissenschaft selbst erst in der neuesten Zeit häufiger und tiefer eindringend unter dem Gesichtspunkte der Entwicklung ins Auge gefasst. Und doch gilt gerade hier der Satz, daß sich erst aus der Einsicht in das Werden ein richtiges Verständnis für das Gewordene gewinnen läßt.

Eine bedeutende Anregung empfing die Geschichte der Wissenschaften um die Mitte des vorigen Jahrhunderts durch die Bayrische Akademie. Sie ließ nämlich die Geschichte der einzelnen Wissenszweige durch hervorragende Fachleute bearbeiten. So entstanden die Geschichte der Botanik von Sachs, die Geschichte der Zoologie von Carus, die Geschichte der Astronomie von Wolff usw. Etwa zur selben Zeit, als die Bayrische Akademie ihr großes Unternehmen ins Werk setzte, entstand Poggendorffs biographisch-literarisches Handwörterbuch, das noch heute und noch wohl für lange Zeit als eins der wichtigsten Hilfsmittel der historischen Forschung zu betrachten ist. Die Geschichtsschreibung auf naturwissenschaftlichem Gebiete nahm während des 19. Jahrhunderts nicht nur an Umfang zu, sondern sie ging auch mehr in die Tiefe. Das bloße Verzeichnen der Tatsachen und das[Pg 2] biographische Moment traten zurück gegenüber dem Bestreben, die allmähliche Entwicklung der Gedanken zu verfolgen. In dieser Hinsicht fand die Geschichte der Naturwissenschaften gute Vorbilder in der neueren Behandlung der Geschichte der Philosophie und in der Literaturgeschichte. Wie man es auf diesen Nachbargebieten gelernt hatte, vor allem in das Werden und in das Reifen der philosophischen oder der literarischen Richtungen und Einzelschöpfungen einzudringen, so erblickte man auch auf unserem Gebiete die Hauptaufgabe immer mehr in der Darstellung des Werdens, der Klärung der grundlegenden Begriffe und darin, diesen Vorgang des Werdens aus möglichst allen Umständen und treibenden Ursachen heraus zu verstehen. Als ein Beispiel für diese Art der Geschichtsschreibung kann Dührings kritische Geschichte der allgemeinen Prinzipien der Mechanik gelten. Auch die bekannten historisch-kritischen Werke von Mach über die Mechanik und über die Wärmelehre gehören hierher.

Was das 19. Jahrhundert auf dem Gebiete der Wissenschaftsgeschichte bot, blieb indessen, von wenigen Ausnahmen abgesehen, Spezialgeschichte. Neben besonderen Geschichtswerken über Mechanik und Wärmelehre entstanden solche über Optik, Elektrizitätslehre, Elektrochemie, Geologie, Meteorologie, Mineralogie usw. So wichtig die historische Bearbeitung begrenzter Teilgebiete ist, so wenig interessiert sie weitere Kreise. Man kann nicht einmal dem Physiker, geschweige denn dem Studierenden der Physik zumuten, sich über die Geschichte eines jeden Teilgebietes dieser Wissenschaft durch ein besonderes Werk zu unterrichten. Auch auf chemischem Gebiete ist die Anzahl der geschichtlichen Werke nicht gering. Ein Mangel, der den meisten anhaftet, besteht darin, daß sie zu wenig die Beziehungen zu den übrigen Wissensgebieten und zum allgemeinen Gange der Kulturentwickelung aufdecken. Eine Ausnahme hiervon bildet die Geschichte der induktiven Wissenschaften von Whewell. Das Werk gehört indessen der ersten Hälfte des neunzehnten Jahrhunderts und damit eigentlich selbst schon der Geschichte an. (Eine deutsche Übersetzung erschien vor 70 Jahren.)

Eine Geschichtsschreibung, wie wir sie für die Naturwissenschaften neben Einzeldarstellungen brauchen, muß diese Wissenschaften im Rahmen der Gesamtentwickelung darstellen. Ferner ist der Werdegang der Naturwissenschaften nicht nur als ein Ergebnis der gesamten Kultur, sondern auch unter Bezugnahme auf die Entwicklung der übrigen Wissenschaften, insbesondere der[Pg 3] Philosophie, der Mathematik, der Medizin und Technik zu verfolgen. Vor allem ist zu zeigen, wie sich diese Zweige des Denkens und der Forschung gegenseitig gefordert und bedingt haben. Eine von einer solchen Auffassung durchdrungene Darstellung der Geschichte der Naturwissenschaften wäre vielleicht imstande, Du Bois Reymonds Wort, daß sie die eigentliche Geschichte der Menschheit sei, zu rechtfertigen[1].

Zur Belebung des Studiums der Wissenschaftsgeschichte ist bisher nur wenig geschehen. Die zur Pflege dieses Studiums auf der Hamburger Naturforscherversammlung im Jahre 1901 ins Leben gerufene Deutsche Gesellschaft für Geschichte der Medizin und der Naturwissenschaften zählt augenblicklich nur einige hundert Mitglieder. In diese Zahl sind aber auch Institute und Bibliotheken eingeschlossen, welche die Mitgliedschaft nur deshalb erworben haben, um die regelmäßig erscheinenden Veröffentlichungen der Gesellschaft ihren Bücherbeständen einzuverleiben. Ihren eigentlichen Hort findet die Geschichte im weitesten Sinne auf den Hochschulen, die ja selbst fast alle eine Jahrhunderte umfassende Geschichte hinter sich haben. Eingedenk des alten heraklitischen Wortes, daß nicht in der Kenntnis des einzelnen Gewordenen, sondern auf der Kenntnis des Werdens die Vernunft beruht, wird auf den Hochschulen neben der allgemeinen Geschichte eine ganze Reihe von historischen Sondergebieten gepflegt. Nur hinsichtlich der Wissenschaftsgeschichte haben die Universitäten und leider auch die technischen Hochschulen bisher eine Ausnahme gemacht. Und doch gilt es gerade hier, die größten und lohnendsten Aufgaben auf dem Gebiete der Geschichtsforschung und in der Pflege des historischen Sinnes zu erfüllen. Den Versuch, umfassende Vorlesungen über die Geschichte der Wissenschaften zu veranstalten, hat man bis jetzt nur in Wien und gelegentlich in München unternommen. Was man hin und wieder findet, sind Vorlesungen über eng begrenzte Gebiete. So weisen die Vorlesungsverzeichnisse für das Sommersemester 1911 einige einstündige Kollegs über neuere Geschichte der Chemie, die Experimentierkunst des Paracelsus, die Entstehung des Getreidebaues, die Kulturgeschichte der Nutz- und Medizinpflanzen und ähnliches auf. »Vollständige Vorlesungen über die Geschichte der Mathematik, Astronomie, Geologie, Botanik, Zoologie, Geographie sucht man[Pg 4] überall vergebens«2. Ja, es gibt sogar eine ganze Anzahl von Universitäten, an denen nicht einmal das bescheidenste historische Spezialkolleg über die Entwicklung der so gewaltig emporgeblühten Naturwissenschaften gehalten wird, während Vorlesungen über die Geschichte der verschiedenen Künste, der Literaturen, der philosophischen Systeme usw. nirgends fehlen. Im Sommer 1911 waren es nicht weniger als 15 deutsche Universitäten, an denen überhaupt keine historische Vorlesung aus den Gebieten der Mathematik und der Naturwissenschaften gehalten wurde3. Es befanden sich darunter Universitäten wie München, Bonn und Göttingen. Hoffentlich tritt hierin bald eine Wandlung ein. Ganz besonders müßte es sich München als Sitz des Deutschen Museums für Geschichte der Naturwissenschaften und der Technik angelegen sein lassen, in Verbindung mit jenem Museum die Geschichte der Naturwissenschaften nicht ausschließlich durch die Anhäufung toter Gegenstände, sondern auch durch das lebendige Wort zu pflegen.

Mit der Frage, wie dem bestehenden Mangel des Hochschulunterrichtes abzuhelfen sei, hat sich als das hierzu ganz besonders berufene Organ die Deutsche Gesellschaft für Geschichte der Medizin und der Naturwissenschaften wiederholt beschäftigt. Im Jahre 1903 gelangte diese Gesellschaft einstimmig zu der Forderung, daß an den Hochschulen nicht nur gelegentlich, sondern regelmäßig und systematisch über die Entwicklung sowohl der Heilkunde als auch der einzelnen Naturwissenschaften Lehrvorträge gehalten werden sollten4.[Pg 5] Eine so weitgehende Forderung hat aber zunächst kaum Aussicht auf Verwirklichung. Man beschränke sich deshalb lieber darauf, für die Geschichte der Medizin und für die Geschichte der Naturwissenschaften je einen Lehrstuhl zu fordern. Das Bedenken, daß der einzelne nicht imstande sei, die sämtlichen Gebiete der Medizin oder der Naturwissenschaft in den Bereich seines Forschens und Denkens zu ziehen, ist nicht stichhaltig. Mit Recht bemerkt hierzu Professor Sigmund Günther in München, der wiederholt für eine bessere Pflege der Geschichte der Naturwissenschaften eingetreten ist, das folgende: »Nicht um Detailwissen, nicht um Beschäftigung mit Einzelproblemen handelt es sich hier, sondern darum, ein Bild von den großen Ideen sowohl als von den Errungenschaften, die man ihnen verdankt, zu zeichnen.« Mit feinem Spott wendet sich Günther gegen die leider nicht selten anzutreffende Meinung, daß es das Wahrzeichen eines richtigen Gelehrten sei, sich selbst auf den seinen Studien naheliegenden Gebieten als ein vollständiger Laie zu erweisen, und nur als Kenner ersten Ranges auf seinem eigenen, engen Arbeitsfelde gelten zu wollen.

Gerade in Anbetracht dieses, von Günther nicht mit Unrecht verspotteten Mangels muß auf die große Bedeutung der geschichtlichen Betrachtungsweise immer wieder hingewiesen werden. Je mehr sich nämlich die Tätigkeit des einzelnen Forschers auf ein kleines, im Verhältnis zur Wissenschaft manchmal recht winziges Arbeitsfeld beschränkt, um so dringender ist es notwendig, von Zeit zu Zeit den Blick auch wieder auf die Gesamtwissen[Pg 6]schaft zu richten. Sie in ihrem gegenwärtigen Umfange zu überschauen, ist allerdings nicht möglich. Wohl aber können wir sie uns in einem geschichtlichen Rückblick vergegenwärtigen, die Haupttatsachen und die wichtigsten Gedanken verfolgen, sie verknüpfen und so zu einer vertieften Auffassung gelangen.

Eine wertvolle Frucht des geschichtlichen Studiums ist auch darin zu erblicken, daß es vor übertriebener Einseitigkeit bewahrt. Ist doch die allzu einseitige Betonung bestimmter Richtungen in der Wissenschaft nicht selten ein Hemmnis für ihre Entwicklung gewesen. Die Geschichte lehrt bis in die neueste Zeit, daß solche Einseitigkeiten meist auf Rechnung der berufsmäßigen Vertreter der Wissenschaft zu setzen sind. So waren beispielsweise die Botaniker von Fach ausschließlich mit dem Ausbau des Linnéschen Systems beschäftigt, als der Rektor Sprengel die Blütenbiologie begründete und damit der Wissenschaft seiner Zeit um Jahrzehnte vorauseilte. Und als hundert Jahre früher Grew und Hales die Anfänge einer wissenschaftlichen Anatomie und Physiologie der Pflanzen schufen, schenkten ihnen die Fachbotaniker kaum Beachtung. Ähnliche Beispiele lassen sich aus jedem Gebiete anführen, ohne daß dadurch die Stetigkeit und Folgerichtigkeit in der Entwicklung der Wissenschaft, wenn wir sie als großes Ganzes ins Auge fassen, eine Unterbrechung erlitten hätte.

Die genetische Betrachtungsweise ist ferner wie nichts anderes geeignet, vor dogmatischer Überschätzung der heute geltenden Theorien zu bewahren. Wer sich der historischen Betrachtung verschließt, ist leicht geneigt, an ein unvermitteltes Entstehen der Theorien zu glauben. Ein Beispiel aus der neuesten Zeit bietet das Aufkommen der Ionentheorie. Arrhenius, der zu den Schöpfern der neuesten chemischen Vorstellungen zählt, hat in einer ausführlichen historischen Darlegung nachgewiesen, »daß die neuen theoretischen Vorstellungen aus den alten, allgemein anerkannten Ideen herausgewachsen sind«5. Gerade das, sagt er, ist ihr verheißungsvollster Zug. Denn ohne Zweifel ist es ein Beweis, daß man sich auf dem rechten Wege befindet, wenn sich in der Entwicklung der Theorien eine logische Konsequenz beobachten läßt.

Diese Konsequenz, verbunden mit einer stetig zunehmenden Läuterung der Vorstellungen, gibt der Geschichte der Naturwissenschaften ein Gepräge, über das man immer wieder staunen muß.[Pg 7] In welchem Maße gilt dies z. B. von dem Weltbild, das sich im Wandel der Zeiten aus der Beobachtung der Himmelserscheinungen ergeben hat! Die Grundzüge der Astronomie lassen sich gar nicht darstellen, ohne auf die Forschungen, Vorstellungen und Gedankengänge eines Koppernikus, Kepler, Newton, Laplace, Herschel fortgesetzt Rücksicht zu nehmen. Das gleiche gilt in der Physik von Archimedes, Galilei, Guericke, in der Chemie von Lavoisier, Dalton, Berzelius, Liebig und zahlreichen anderen großen Forschern.

Wie in jeder Geschichte, so spielt auch in der Wissenschaftsgeschichte das biographische Moment eine, wenn auch mehr nebensächliche Rolle. Ich glaube, daß die früher allzu starke Betonung dieses Momentes die Wissenschaftsgeschichte etwas herabgesetzt und ihre wahre Bedeutung verschleiert hat. Was will es für die Entwicklung der Naturwissenschaften z. B. heißen, ob Galilei das Wort: »Und sie bewegt sich doch!« wirklich gesprochen hat oder nicht, ob er seine Fallversuche vom schiefen Turm in Pisa anstellte oder von irgend einem anderen. Für die Spezialforschung mögen solche Dinge ein gewisses Interesse haben. Für das Emporkommen einer das geistige Leben durchdringenden Geschichte der Naturwissenschaften ist ihre Häufung jedenfalls nachteilig. Mit Recht wird man das biographische Moment stets dann verwerten, wenn es zum Verständnis der Entwicklung wesentlich beiträgt. So ist es beispielsweise von Bedeutung, daß Kepler zu Tycho, dem unerreichten Meister der astronomischen Meßkunst, in ein persönliches Verhältnis trat, weil er dadurch die astronomischen Daten über den Mars erhielt und in den Stand gesetzt wurde, die Gesetze der Planetenbewegung zu entdecken.

Bei der Beurteilung des biographischen Momentes darf ferner nicht vergessen werden, daß oft erst aus der Kenntnis der großen Persönlichkeit, deren Schaffen wir miterleben und des allgemeingeschichtlichen Hintergrundes, von dem sie sich abhebt, das tiefere Verständnis für den Verlauf und das schließliche Ergebnis des geistigen Fortschritts erwächst. In einer Betrachtung der Naturwissenschaften unter diesem Gesichtswinkel liegt auch ein Teil ihrer ethischen Wirkung. Die großen Forscher bieten meist glänzende Beispiele geistiger und sittlicher Selbstzucht. Die Taten, die sie auf dem Felde der Wissenschaft verrichteten. verdienen die höchste Bewunderung. Um sich ihren Idealismus zu bewahren, muß sich unsere Zeit für die Führer der Menschheit begeistern,[Pg 8] zu denen die Schöpfer der Wissenschaft und der Technik nicht minder zählen als die großen Dichter und Denker.

Eine ähnliche Bedeutung wie für die Forschung und das Studium besitzt die geschichtliche Betrachtungsweise für den naturwissenschaftlichen Unterricht und damit für die Allgemeinbildung. Allerdings wird ihre Bedeutung hier bislang noch weniger gewürdigt, während doch nichts so sehr imstande ist, den naturwissenschaftlichen Unterricht wahrhaft humanistisch zu gestalten wie die genetische Betrachtungsweise. In der Regel begnügt man sich damit, einige Namen und historische Daten mitzuteilen, die nur das Gedächtnis belasten. Und doch gibt es kein wirksameres Mittel, den Unterricht zu beleben, als das Eindringen in das geschichtliche Werden der Probleme. Selbstverständlich sollen nach wie vor Beobachtung und Versuch im Vordergrunde stehen und die fundamentalen Gesetze auf induktivem Wege erarbeitet werden. Aber gerade auf diesem Wege kann das genetische Verfahren in viel höherem Maße, als es bisher geschehen, das verständnisvolle Eindringen in den Zusammenhang der Erscheinungen unterstützen.

Eine nicht geringere Bedeutung wie für das Gebiet der Naturwissenschaften besitzt die historische Forschung und die Erziehung zum historischen Denken für die Anwendungen dieser Wissenschaften, die Medizin und die Technik. Drängt doch nach dem Urteil Berufener gerade auf diesen Gebieten die Fülle des Stoffes zu einer Zersplitterung, die schließlich dazu führt, daß das geistige Band, das die Einzelgebiete verknüpfen soll, verloren geht und kritikloses Arbeiten nach vorgeschriebenem Gange an seine Stelle tritt. Infolge dieser Erkenntnis regt sich auch auf den Gebieten der angewandten Naturwissenschaften das Bemühen, den Blick über das lediglich Nützliche hinaus auf den tieferen Gehalt und den Werdegang, den diese Wissenschaften innerhalb des Verlaufes der Kulturentwicklung genommen haben, zu richten.

Nach der Auseinandersetzung der für das Verhältnis der Wissenschaft zu ihrer Geschichte wesentlichen Gesichtspunkte seien die wichtigsten Phasen der Wissenschaftsgeschichte noch einmal kurz hervorgehoben, um daran die weitere Schilderung anzuknüpfen.

Man hat lange Zeit die Mathematik und die Naturwissenschaften für Schöpfungen der Griechen gehalten und den Anteil, den die Völker des alten Orients an diesen Schöpfungen hatten, nur gering bewertet. Heute ist indessen sicher, daß eine große Fülle von Beobachtungen und Erfahrungen gesammelt und auch[Pg 9] schon bis zu einem gewissen Grade gesichtet wurden, bevor die Griechen unter teilweiser Verwendung dieses Materials an den systematischen Aufbau der Wissenschaften herangetreten sind. Daß unserem Zeitalter diese mühevolle Vorarbeit bekannt geworden ist, verdankt es der modernen Archäologie, der Wissenschaft vom Spaten. Erst im 19. Jahrhundert wurde nach und nach der Schutt hinweggeräumt, der die in Trümmer versunkenen Stätten der uralten Kultur im Niltal und am Euphrat deckte. Zu vielen Tausenden fand man Tonplatten, die nach ihrer Reinigung Schriftzüge erkennen ließen. Diesen Keilschrifttafeln verdanken wir die Einsicht, daß die Naturwissenschaften und die Mathematik ein Alter besitzen, das man in früherer Zeit, als jedes Verdienst der verhältnismäßig jungen Kultur der Griechen zugeschrieben wurde, nicht ahnte.

Man hat wohl behauptet, daß die Wissenschaft erst mit dem Augenblick beginne, in dem der Mensch sich der Erforschung eines Gegenstandes ohne alle Nebenrücksichten widmet. Will man sich dieser Erklärung anschließen, so darf man allerdings von einer Wissenschaft des alten Orients und Ägyptens nicht reden. Die Sternkundigen z. B. kannten damals nur zwei Aufgaben. Zu beiden stand der Mensch mit seinem Fürchten und Hoffen in engster Beziehung. Es galt einmal, die Zeitrechnung festzusetzen und zweitens, aus den Sternen Menschen- und Völkerschicksale zu deuten. Aber hat sich der Mensch nicht stets als Mittelpunkt bei seinem Tun und Denken gefühlt? Sind nicht die Chemie, die Medizin, die Botanik aus ähnlichen Trieben hervorgegangen? Selbst die Mathematik, die sich so gern als reine Wissenschaft bezeichnet, macht keine Ausnahme. Die Griechen hatten nicht so Unrecht, wenn sie annahmen, daß die Ägypter durch die Vermessung ihrer Ländereien auf die ersten geometrischen Sätze geführt worden seien. Richtiger ist es also, den Beginn der Wissenschaft auf jene Zeit zurückzuführen, in der zuerst sorgfältig beobachtet und die gewonnenen Ergebnisse als Gemeingut, sei es mündlich, sei es schriftlich, fortgepflanzt wurden. So war es zweifelsohne schon eine beachtenswerte wissenschaftliche Leistung, daß die Astronomen Babylons durch Jahrhunderte währende Beobachtungen eine gewisse Regel in der Wiederkehr der Finsternisse erkannten. Auf Grund dieser Regel waren sie sogar imstande, die Finsternisse mit einiger Wahrscheinlichkeit vorherzusagen. Und gerade diese Kunst, ein Geschehnis aus der Kenntnis des Naturablaufes vorherzusagen,[Pg 10] hat man mit Recht auch wohl als ein Charakteristikum der Wissenschaft bezeichnet.

Vor allem aber verdient genaues Beobachten dann als eine wissenschaftliche Tätigkeit bezeichnet zu werden, wenn sich dem Beobachten das Messen und Vergleichen zugesellt. Und an Messungen, die in Anbetracht der rohen Hilfsmittel, auch heute noch Bewunderung erregen, haben es die Alten nicht fehlen lassen.

Zu astronomischen Messungen benutzte man in Grade eingeteilte Kreise. Mit ihrer Hilfe wurde der Abstand der Sterne voneinander, vom Pol, vom Himmelsäquator und vom Horizont ermittelt. Auf diese Weise entstand eine Topographie des Fixsternhimmels mit genauer Ortsangabe für die einzelnen Gestirne.

Schon früher hatte man eine Anzahl einander benachbarter hellerer Sterne als Gruppen, als Sternbilder, auffassen gelernt. Daß man Sternen und Gruppen von Sternen Namen gab und ihre Bewegung verfolgte, war der zweite Schritt auf dem Wege, auf dem der Mensch in das Weltall eingedrungen ist. Der erste Schritt ist immer das bloße Beobachten gewesen. Die zunächst unbestimmten Eindrücke schärfer erfassen und sie ordnen, das heißt, sie unter Namengebung in ein gewisses System eingliedern, das weiteres Beobachten fordert und eine leichtere Verständigung herbeiführt, das war stets der zweite Schritt.

Das erste Weltbild, zu dem die Wissenschaft des Altertums gelangte, war dasjenige der unmittelbaren naiven Anschauung. Wie eine gewaltige Scheibe erschien der Wohnsitz der Menschheit. Jenseits der Säulen des Herkules und der Ufer des Schwarzen Meeres, sowie nördlich vom Lande der Hyperboreer und südlich der libyschen Wüste sollte der Ozean als eine kreisförmige Wassermasse die Erdscheibe begrenzen.

So klein wie der geographische Gesichtskreis nach heutigen Begriffen war, so eng war auch der kosmische. Welt und Erde fielen in der Hauptsache zusammen. Über der Erdscheibe ruhte der Himmel als ein wirkliches, aus festem oder flüssigem Stoff bestehendes Gewölbe. Der im Mittelpunkte ruhenden Erde, als dem Orte des Unbeständigen, stellte man die sie umkreisenden Gestirne als die Welt des Unveränderlichen gegenüber. Erst aus der Überwindung dieses Gegensatzes entsprang die Vorstellung vom All, wie sie die Neuzeit nach dem Wiederaufleben der Wissenschaften seit Koppernikus, Kepler und Galilei geschaffen hat.

Eine Erweiterung des ersten, engbegrenzten Weltbildes fand noch während des griechischen Geisteslebens statt. Diese Erweiterung kam dadurch zustande, daß sich zum Beobachten und zum Messen die geometrische Betrachtungsweise gesellte. Daraus erwuchs die reine Wissenschaft, die in der steten Verknüpfung von Beobachten, Messen und Schließen besteht. Während dieser, schon im Altertum erklommenen Stufe erweiterte sich das Himmelsgewölbe zur Himmelskugel und die Erdscheibe zu der freischwebenden, kugelförmigen Erde.

Die ersten Zweifel, ob man es bei der Erde wirklich mit einer Kugel zu tun habe, entstanden bei weiten Reisen. Begab man sich von Griechenland nach Ägypten, so tauchten im Süden Sterne auf, die man in Griechenland nicht zu sehen bekam. Um von diesen und ähnlichen Beobachtungen aus zu der Vorstellung der kugelförmigen Gestalt der Erde zu gelangen, dazu bedurfte es jedoch keines geringen Abstraktionsvermögens. Sobald man aber die Erde für eine Kugel hielt, war der erste Schritt zu jener Vorstellung vom Kosmos, die wir heute hegen, getan. Lag es doch nahe, die gewonnene Anschauung mit der Annahme zu vereinen, daß Mond und Sonne als ähnliche große Kugeln, weit entfernt von der Erde, frei im Raume schweben.

Mit dieser im griechischen Altertum entstandenen Erweiterung des Weltbildes waren zwei der großartigsten Probleme gegeben, welche die Menschheit bis in die Gegenwart hinein mit immer größerer Genauigkeit zu lösen gesucht hat. Es galt nicht nur die Größe der Erdkugel, sondern auch ihren Abstand von den benachbarten Himmelskörpern zu bestimmen.

Den Gedanken, die Größe der Erdkugel zu ermitteln, verwirklichte der alexandrinische Gelehrte Eratosthenes. Es hat Zeiten gegeben, in denen man von den Leistungen der Alten mit hochmütiger Geringschätzung sprach. Wer zu einem etwas tieferen Verständnis der Geschichte der Wissenschaften gelangt ist, wird der Erdmessung des Eratosthenes und ähnlichen Problemen, welche die Alten lösten, seine Anerkennung nicht versagen und einsehen, daß die Begründung der neueren Wissenschaft dadurch erfolgte, daß man auf die Arbeiten der Alten zurückgriff. In ganz besonderem Maße gilt das von der Astronomie und damit von der Entstehung des modernen Weltbildes.

Die Bestimmung des Erdumfanges durch Eratosthenes bildete sozusagen den Hebel für das Problem, messend über die[Pg 12] Erde hinauszugelangen und auf diese Weise in die Gliederung des Weltgebäudes einzudringen. Zuerst gelang es Aristarch, von der Größe und der Entfernung der uns nächsten Weltkörper ein annähernd richtiges Bild zu erhalten. Aristarch legte die Ergebnisse seiner Messungen und seines Nachdenkens in einer Schrift »Über die Größen und Entfernungen der Sonne und des Mondes« nieder. Aus dieser Schrift, von der einiges erhalten geblieben ist, ersieht man, daß Aristarch den Mond für etwa 30 (statt 48) mal so klein, die Sonne dagegen für 300 (statt 1,300,000) mal so groß wie die Erde hielt. Die mittlere Entfernung des Mondes von der Erde bestimmte Hipparch zu 59 (statt 60) Erdhalbmessern. Da man die Größe der Erde durch Eratosthenes kennen gelernt hatte, so ließ sich der Abstand Erde-Mond sogar in absolutem Maß ausdrücken.

Da Aristarch mit ziemlicher Sicherheit zu schließen vermochte, daß die Sonne ein viele tausendmal größerer Weltkörper ist als unser Trabant und daß sie auch die Erde ganz erheblich an Größe übertrifft, so regte sich in ihm der Zweifel, ob die Erde tatsächlich den Mittelpunkt des Ganzen bilde und die um so viel größere Sonne sich wirklich um die Erde bewege. So kam es, daß Aristarch die heliozentrische, die Sonne als Mittelpunkt des Alls betrachtende Lehre schon 1800 Jahre vor Koppernikus aussprach. Trotzdem siegte, als im 2. Jahrhundert n. Chr. die Astronomie durch Ptolemäos in ein System gebracht wurde, die geozentrische Ansicht. Das Ptolemäische System blieb während des Altertums und durch das ganze Mittelalter hindurch in Geltung. Das Wesentlichste und die Mitte der Welt war danach die im Zentrum ruhende Erde. Um sie bewegten sich der Mond, die Sonne, die Planeten und der gesamte Fixsternhimmel.

Man mußte mancherlei Annahmen machen, um die am Himmel beobachteten Vorgänge mit diesem System in Einklang zu bringen. Die größten Schwierigkeiten machten die Planeten. Bei ihnen wechselte nicht nur die Geschwindigkeit, mitunter schienen sie sogar stillzustehen, und schließlich bewegten sie sich auf ihrer Bahn zeitweise in umgekehrter Richtung. Um dies alles zu erklären, ohne den Grundsatz der gleichmäßigen und kreisförmigen Bewegung der Weltkörper zu verlassen, ließ man die Planeten in einem Epizykel laufen, d. h. in einem kleineren Kreise, dessen Mittelpunkt sich auf einer größeren Kreisbahn um die Erde bewegen sollte. Je genauer man den Lauf der Planeten beobachten lernte, um so weniger entsprachen die Beobachtungen der immer[Pg 13] verzwickter werdenden Epizyklentheorie. Doch sollten gerade die Irrwege, in die sich die Astronomen des Altertums und des Mittelalters verrannt hatten, für Koppernikus der Anlaß werden, über eine andere Möglichkeit des Weltenbaues nachzusinnen.

Wie für die Astronomie, so wurden auch für die übrigen Zweige der Naturwissenschaften während des Altertums die wichtigsten Grundlagen geschaffen. Es kann indessen hier nicht im einzelnen wiederholt werden, wie weit der Mensch im Altertum in der Erforschung des eigenen Körpers und der übrigen Lebewesen, der Mineralien und der Gesteine, sowie der physikalischen und chemischen Kräfte gelangt ist. Nur das eine sei hervorgehoben, daß damals auch auf diesen Gebieten das Fundament gelegt wurde, auf dem die Neuzeit nach dem Wiederaufleben der Wissenschaften, also etwa seit dem 16. Jahrhundert, weiterbauen konnte, um zur Beherrschung der Natur und zu jenem Weltbild zu gelangen, das wir heute als das wichtigste theoretische Ergebnis der gesamten naturwissenschaftlichen und naturphilosophischen Forschung besitzen.

Als einen der wesentlichsten Mängel des Altertums hat man es immer betrachtet, daß das Experiment zu wenig gewürdigt wurde. Es ist indessen eine Übertreibung, wenn man sagt, die Alten hätten nicht experimentiert. Das Hüttenwesen, die Metallurgie, die Glasbereitung, die Färberei und viele andere Zweige des gewerblichen Lebens regten im Altertum zu zahlreichen Versuchen an. Dafür, daß mitunter auch der Gelehrte experimentierte, ist der große Mathematiker und Physiker Archimedes ein Beispiel. Durch seine Verknüpfung der mathematischen Betrachtungsweise mit sinnreich ausgedachten Versuchen wurde er der Schöpfer der wissenschaftlichen Mechanik.

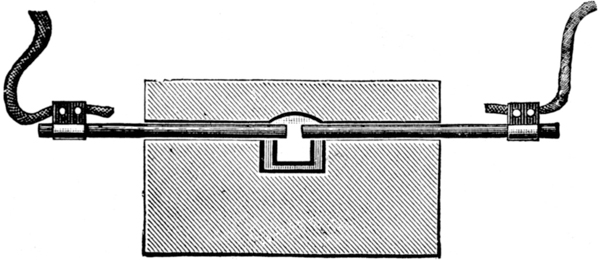

Zahlreiche Untersuchungen über das Verhalten der Gase und der Dämpfe stellten die alexandrinischen Gelehrten an. Einer von ihnen verwendete den Dampf sogar schon zum Betriebe einer maschinellen Vorrichtung. Ein anderer führte eine ganze Versuchsreihe durch, um das als Brechung bekannte Verhalten eines Lichtstrahls, der in Wasser eindringt, kennen zu lernen. Seine Ergebnisse waren so genau, daß neuere Messungen sie bis auf geringe Abweichungen bestätigt haben. Zur Zeit der Römer wurden sogar vivisektorische Untersuchungen angestellt, um das Zusammenwirken von Nerven und Muskeln zu erforschen. Allerdings war man im Altertum geneigt, den mühevollen Weg des Versuches abzukürzen, und lieber von allgemeinen Sätzen auszugehen. Ein Beispiel dafür boten die[Pg 14] Pythagoreer. Sie hatten entdeckt, daß sich harmonische Töne ergeben, wenn man eine Saite nach einfachen Verhältnissen teilt. Von diesem Ergebnis ausgehend, stellten sie den Satz auf, daß alles in der Welt in ganz bestimmter Weise nach Maß und Zahl geordnet sei. Unter den griechischen Denkern war besonders Plato von diesem Gedanken beherrscht.

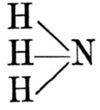

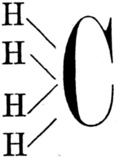

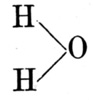

An die Spekulationen über Form, Maß und Zahl reihte sich die Frage nach dem Stoff, aus dem die Welt besteht. Nach der Vorstellung der ersten Naturphilosophen ist die Welt aus einem Urstoff geformt. Dem einen schien dafür das Wasser besonders geeignet. Andere hielten die Luft für die Urmaterie. Aus ihrer Verdichtung sollten die flüssigen und die festen Körper entstanden sein. Den längsten Bestand hatte die Lehre, daß sich die Welt aus vier Elementen gebildet habe, aus Erde, Feuer, Luft und Wasser. Aus ihnen waren danach alle irdischen Dinge hervorgegangen. Die Gestirne dagegen sollten aus einer besonderen, fünften Substanz (Quintessenz) bestehen.

Mit der Lehre von einem Urstoff, der übrigens auch den vier Elementen zugrunde liegen sollte, konnte man sich indessen nicht begnügen. Man erkannte, daß man dem Stoff ein formgebendes, gestaltendes Prinzip zur Seite stellen mußte. Aristoteles nannte es Seele. Ein anderer forderte einen nach Zwecken schaffenden Weltgeist. Ein dritter legte dem Stoff zwei Kräfte bei, die er als Liebe und Haß bezeichnete. Damit waren die Keime der mechanischen Naturerklärung gegeben. Man braucht nur statt Liebe und Haß Anziehung und Abstoßung zu setzen und den Urstoff nach dem Vorgang Leukipps und Demokrits in unveränderliche Teilchen (Atome) aufzulösen, um die Vorstellungen zu erhalten, welche die neuere Naturwissenschaft ihren Bestrebungen, die Welt mechanisch zu erklären, zugrunde gelegt hat.

Wie die Begriffe Stoff und Form, so gehören auch die Vorstellungen des Wechsels, des Werdens und Fließens zu den primitivsten. Auch diese Vorstellungen bildeten die Grundlage eines naturphilosophischen Systems der Alten.

Hand in Hand mit solchen Vorstellungen entstanden schon im Altertum die ersten Ansätze zu einer Entwicklungslehre im biologischen Sinne. Wer denkt nicht an die Urzelle, wenn es heißt, durch die Sonnenwärme seien im Schlamm zuerst blasige Gebilde entstanden. Klingt es nicht ferner wie eine Stelle aus Lamarcks oder Darwins Werken, wenn daran die Bemerkung geknüpft[Pg 15] wird, aus diesen Bläschen hätten sich zuerst fischartige Geschöpfe gebildet, von denen einige ans Land gekrochen seien? Diese Änderung der Lebensweise habe zu einer Umwandlung der Gestalt geführt. Auf solche Weise seien zunächst die landbewohnenden Tiere und schließlich der Mensch entstanden.

Dennoch wäre es grundfalsch anzunehmen, die Geistesschöpfungen der Neuzeit seien nur Wiederholungen dessen, was sich schon bei den alten Schriftstellern findet. In vielen Fällen handelt es sich bei den Alten nur um gelegentliche geistreiche Einfälle. Daß sich darunter neben einer Menge von haltlosen Behauptungen auch manches Zutreffende findet, darf nicht wundernehmen. Auch von einem anderen Gesichtspunkte aus kann man es verstehen, daß manche Begriffe und Vorstellungen der Alten in dem Wissenschaftsgebäude der Neuzeit wiederkehren. Im Grunde genommen ist doch der Mensch in geistiger und körperlicher Hinsicht im geschichtlichen Altertum das gleiche Wesen wie in der Neuzeit. Die zwei Jahrtausende Zeitunterschied spielen in Anbetracht der Dauer seiner Entwicklung keine große Rolle. Und wie die ältesten Werkzeuge und Maschinen mit den neueren Hilfsmitteln der Technik bis zu einem gewissen Grade übereinstimmen, selbst wenn wir bis zu vorgeschichtlichen Zeiten zurückgehen, so verhält es sich auch mit den Elementen des Denkens und Forschens. Um Keime handelt es sich auf diesem wie auf allen übrigen Gebieten. Diese Keime haben sich im Laufe der Jahrtausende zu dem Baum entwickelt, als dessen Früchte wir heute die Segnungen unserer materiellen und geistigen Kultur genießen.

Auf das Altertum folgt der wohl ein Jahrtausend umfassende Zeitraum, den die Historiker das Mittelalter nennen. Das Mittelalter ist so häufig falsch gezeichnet worden, daß sich noch heute wenige ein zutreffendes Bild davon machen. Kunst und Wissenschaft der Alten, ja ihre ganze Kultur sollte sich unter Schutt und Ruinen verloren haben. Ein tiefer Riß, der die bisherige Entwicklung jählings unterbrach, sollte durch die Menschheitsgeschichte gegangen sein. Stimmt diese Ansicht, wie war es dann möglich, daß der Mensch der neueren Zeit überall auf den vom Altertum geschaffenen Grundlagen fortbauen konnte? Ist etwa das Wiederaufleben der Antike der rein zufälligen Entdeckung erhaltener Überreste zu danken? Wir dürfen heute sagen, daß der Faden der ruhigen Entwicklung nicht durchschnitten wurde. Große Veränderungen und Verschiebungen haben zwar innerhalb des als Mittelalter bezeichneten Jahrtausends stattgefunden. Der Zerfall[Pg 16] des römischen Weltreichs und die Ausbreitung des Christentums mit seinem weltabgewandten Wesen, das Eindringen der Germanen und der Araber in die Mittelmeerländer, die ja das eigentliche Kulturzentrum der alten Welt ausmachten: dies alles war für die weitere Ausgestaltung der Wissenschaften von großer Bedeutung. Es ist auch hier und da ein Stück verloren gegangen, ein Stillstand, selbst ein Rückschritt eingetreten. Forschen und Denken, ihre Ergebnisse sammeln, sichten und von Geschlecht zu Geschlecht, von Zeitalter zu Zeitalter vererben sind aber so grundlegende Äußerungen des menschlichen Geistes, daß sie unmöglich plötzlich aufhören konnten.

Mit der politischen Machtentfaltung der Araber trat an die Stelle der griechischen Literatur allmählich die arabische. Die alten Texte wurden ins Arabische übersetzt; das übernommene Wissen wurde vermehrt und gleichfalls in arabischer Sprache niedergelegt. Man darf es sich indessen nicht so vorstellen, als wenn ein bis dahin kaum bekanntes Volk urplötzlich die Fackel der Wissenschaft ergriffen hätte, und als ob diese erloschen sein würde, wenn nicht zufällig die Araber auf dem Plane erschienen wären. Das Arabische verband in ähnlicher Weise die Völker des Ostens, wie es das Latein in den christlichen Ländern Europas tat. Arabisch und Latein waren im Mittelalter die Sprachen der Wissenschaft und des geistigen Austausches von Volk zu Volk. In beiden Sprachen erhielten sich die Werke der Alten. Als dann um 1450 der Buchdruck entstand, empfing alles Wissen, auch das im ursprünglichen griechischen und lateinischen Text erhaltene, neues Leben. Und es ist kein bloßer Zufall, daß in den Beginn des Zeitalters, das wir als Renaissance bezeichnen, die Erfindung des Buchdrucks fällt.

Durch das Studium des astronomischen Hauptwerkes des Altertums erwachte zuerst die Astronomie zu neuem Leben. Die Astronomie trat ferner in die engste Beziehung zur Nautik, die Nautik wurde angewandte Astronomie. Auch hier handelt es sich wie überall um innere Notwendigkeit. Die griechischen und die phönizischen Seefahrer hatten sich im Dunkel der Nacht zwar auch schon nach den Sternen gerichtet, sie waren aber Küstenfahrer geblieben. Seitdem war die Kulturmenschheit mehr und mehr nach Westen gerückt. Sie hatte das enge Mittelmeer, von dessen Fläche fast überall die Berge der Küste zu sehen sind, verlassen und sich an den Küsten des Atlantischen Ozeans ausgebreitet. So sehr hier auch[Pg 17] das Unbekannte locken mochte, die kühnen Seefahrer, die binnen kurzem den Erdball eroberten, wagten es zunächst doch nicht, sich von der atlantischen Küste zu entfernen. Da war es ein günstiges Zusammentreffen, daß gerade in der zweiten Hälfte des 15. Jahrhunderts die Wiederbelebung der Astronomie erfolgte. Man erfand zu den Meßapparaten der Alten neue hinzu, besonders solche, die sich für den Gebrauch auf dem schwankenden Schiffe eigneten. Die astronomischen Tafeln wurden verbessert, die Trigonometrie, die wichtigste Hilfswissenschaft der Astronomie, aus bescheidenen Anfängen entwickelt und der neueren Astronomie und den mit ihr zusammenhängenden Wissenschaften als willkommene Gabe dargeboten.

Auch Koppernikus, mit dem eine neue Epoche in der Entwicklung der Naturwissenschaften anhebt, empfing die wertvollsten Anregungen aus den Schriften der Alten. Durch das Festhalten an der geozentrischen Lehre war die Astronomie in Schwierigkeiten geraten, weil Lehre und Beobachtungen sich immer weniger deckten, je genauer man beobachten lernte. Um die Wissenschaft aus diesen Schwierigkeiten herauszuführen, gab sich Koppernikus zunächst die Mühe, die alten Schriften daraufhin zu untersuchen, ob nicht irgend jemand einmal der Ansicht gewesen sei, daß die Bewegungen der Gestirne anders verliefen, als es Ptolemäos gelehrt hatte. Sowohl bei Cicero als auch bei einem andern alten Schriftsteller fand Koppernikus die Meinung, daß sich die Erde bewege. Von diesem ersten Keim bis zum Ausbau und zum Beweis des heliozentrischen Systems war ein weiter Weg. Denn eine gelegentliche Äußerung, von der sich später herausstellt, daß sie das Richtige getroffen hat, ist noch keine Entdeckung und noch lange keine Theorie, die ja erst in der Zusammenfassung und Deutung vieler als richtig erkannter Tatsachen besteht. Je mehr Tatsachen mit einer Theorie im Einklang stehen, um so größer ist ihre Wahrscheinlichkeit. Auf einen solchen Nachweis kam es also an und nicht auf die gelegentliche Äußerung eines richtigen Gedankens. An diesen Nachweis wandte Koppernikus die Arbeit seines Lebens.

Die Weltansicht des Koppernikus bedeutet zwar eine ganz außerordentliche Erweiterung der seit alters herrschenden Vorstellungen, sie wich aber von der heutigen doch noch erheblich ab. Für Koppernikus war das Weltall noch eine Kugel von bestimmten Abmessungen. In ihrem Mittelpunkt ruhte die Sonne.[Pg 18] Begrenzt wurde die Weltkugel von der Sphäre der Fixsterne, die ihr Licht wie die Erde und die Planeten von der Sonne erhalten sollten. Erst dem Blick des Dominikanermönches Giordano Bruno erweiterte sich das Fixsterngewölbe zu einem in Raum und Zeit unendlichen Universum. Giordano Bruno war der erste, der die Fixsterne für Sonnen und für Mittelpunkte unzähliger, dem unseren ähnlicher Planetensysteme hielt. Da er sich mit den herrschenden Dogmen in Widerspruch setzte, überlieferte ihn die Inquisition dem Scheiterhaufen.

Fast zur selben Zeit, als man sich bemühte, durch dieses Ketzergericht die Wahrheit zu töten, erwuchs der Forschung ein gewaltiger Bundesgenosse. Von Holland kam nämlich die Kunde, daß dort ein Instrument erfunden sei, mit dem man weit entfernte Gegenstände ganz nahe an das Auge heranbringen könne. Als man durch dieses Instrument zum Himmel blickte, ging eine neue, wunderbare Welt dem Menschen auf. Zu den ersten, die sich des Fernrohrs zu astronomischen Forschungen bedienten, gehörte Galilei, einer der gewaltigsten Forscher und Denker, ein König im Reiche der Wissenschaften. Er entdeckte die Berge des Mondes, die Jupitertrabanten, die Sonnenflecken und die Lichtgestalten der Venus. Eine Entdeckung reihte sich an die andere, und jede war in vollstem Einklang mit der koppernikanischen Lehre.

Alle Gründe, die für diese Lehre sprachen, und alle Widersprüche des Ptolemäischen Systems faßte Galilei schließlich in einem glänzend geschriebenen Buche zusammen, das eine einzigartige Stellung in der Weltliteratur einnimmt.

Der Mann, der das Werk eines Koppernikus und eines Galilei fortsetzte, war Johann Kepler. Durch ihn wurde die heliozentrische Lehre auf den Rang einer wohlbegründeten Theorie erhoben. Was Kepler als das Ergebnis fünfundzwanzigjähriger Arbeit gefunden, läßt sich in wenigen Worten ausdrücken. Der größte Mangel, welcher der koppernikanischen Lehre vor Kepler anhaftete, war die Annahme der Kreisbewegung der Gestirne. Mit einer solchen Annahme wollten die genaueren Beobachtungen nicht übereinstimmen. An dieser Stelle lag, wie so oft in der Entwicklung der Wissenschaften, der Wendepunkt. Wenn sich die Beobachtungen der Theorie nicht anpassen, so muß sie einer neuen Theorie weichen, denn den Ergebnissen der Beobachtung kann man keinen Zwang antun. Sie sind das Ursprüngliche, und ihnen müssen sich die Vorstellungen anbequemen. So dachte[Pg 19] und danach handelte Kepler. Er gab das Axiom der Kreisbewegung auf und nahm an, daß sich die Planeten in einer ovalen Bahn um die Sonne bewegen. Die Beobachtungen und die Theorie entsprachen einander jetzt schon besser. Doch war die Übereinstimmung noch immer nicht vollkommen. Wirkliche Übereinstimmung ergab sich erst, als Kepler annahm, daß sich die Planeten in Ellipsen um die Sonne bewegen.

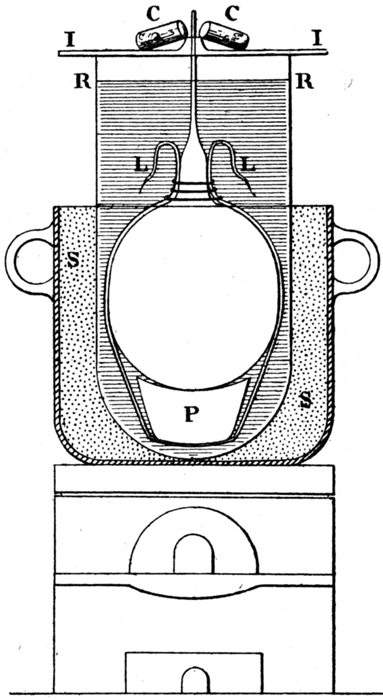

Etwas später als das Wiederaufleben der Astronomie erfolgte eine Neubegründung der übrigen Naturwissenschaften. Schon seit dem 13. Jahrhundert regte sich der Drang nach selbständiger Forschung und nach Befreiung von kirchlichen und wissenschaftlichen Dogmen. In diesem Ringen nimmt das Zeitalter Galileis eine ganz hervorragende Stelle ein. Zum ersten Male wird man sich der großen Bedeutung der experimentellen Forschungsweise voll bewußt. Um sie auszuüben, werden Mittel geschaffen, die man bisher weder kannte noch ahnte. Was nützten alle Bemühungen, in die Natur der Wärmeerscheinungen einzudringen, solange man kein Thermometer besaß? Das 17. Jahrhundert erfand es. Die Philosophen hatten zahllose Spekulationen angestellt über den leeren Raum, über das Wesen der Luft, über die Frage, ob sie Gewicht besitzt oder mit einem Streben vom Erdmittelpunkte fort begabt sei. Im 17. Jahrhundert trat Guericke auf. Er hielt nichts vom Disputieren auf dem Gebiete der Naturwissenschaften, sondern er konstruierte die Luftpumpe und wies das Vorhandensein des Luftdrucks durch den berühmten Versuch mit den Magdeburger Halbkugeln nach. Mit seinem Wasserbarometer untersuchte Guericke die Schwankungen des Luftdrucks. An die Stelle des Wasserbarometers trat das bequemere Quecksilberbarometer. Zur Luftpumpe gesellte Guericke die Elektrisiermaschine. Das Mikroskop erschloß dem Biologen eine neue Welt. Mit einem Worte: sowie das Bestreben, die Natur auf dem Wege des Versuchs zu durchforschen, ernstlich zum Durchbruch kam, schuf der erfinderische Geist eine reiche Fülle von Hilfsmitteln.

Gewiß haben auch die Instrumente nicht dazu verholfen, den letzten Schleier von der Natur der Dinge zu ziehen. Doch es zeugt nur von einer schlechten Kenntnis der Aufgaben der Naturwissenschaft, das von ihr zu verlangen. Alle Forschung ist an die körperlichen und geistigen Grenzen des menschlichen Erkennens gebunden, und die echte Forschung bleibt sich dieser Grenzen stets bewußt.

Man kann alles, was uns jetzt noch in der Ausgestaltung des Weltbildes begegnet, unter einen leitenden Gedanken bringen. Dieser Gedanke, den der einzelne Forscher sich kaum vergegenwärtigte, der sich aber immer deutlicher aus der Forschungs- und Denkarbeit der folgenden Jahrhunderte herausschälte, betrifft das Verhältnis der irdischen Erscheinungen zu den Vorgängen im Kosmos. Ein Hinausprojizieren der Erkenntnisse, die das Experiment an den Dingen der unmittelbaren Umwelt gewonnen hat, begegnet uns schon an der Schwelle des 17. Jahrhunderts. Damals setzte die Erforschung des Magnetismus ein. Man begnügte sich aber nicht damit, die Erscheinungen experimentell zu untersuchen, sondern man erweiterte die erhaltenen Ergebnisse zu der Vorstellung, die Erde sei ein großer Magnet und der Magnetismus eine kosmische Kraft. Ja, man betrachtete diesen kosmischen Magnetismus sogar als die Ursache der Planetenbewegung. Das Gleiche wiederholte sich, als die elektrischen Erscheinungen erforscht wurden.

Daß Licht und Wärme kosmische Kräfte sind, war ohne weiteres klar, da sie ja von der Sonne her den Raum durchfluten. Ein Rätsel blieb es aber, ob auch die Gesetze der Mechanik für den Kosmos gelten. Galilei hatte den Fall, die Pendel- und Wurfbewegung untersucht und ihre Gesetze gefunden. Kepler hatte sich die Frage vorgelegt, ob die Schwerkraft, welche jene Bewegungen regelt, nicht etwa eine kosmische Kraft sei, die sich von der Erde bis zum Monde und von der Sonne auf sämtliche Glieder des Planetensystems erstrecke. Die Beantwortung der Frage, ob die Bewegung der Himmelskörper auf eine Kraft zurückzuführen sei, die auch an die Erde gebunden und daher einer unmittelbaren Erforschung zugänglich ist, sollte jedoch erst durch Newton geschehen. Durch eine Erweiterung der von Galilei gefundenen Gesetze über die Wurfbewegung gelangte er zur Aufstellung des Gravitationsgesetzes.

Es gibt kaum etwas, das man an wissenschaftlicher Bedeutung diesem Gesetz zur Seite stellen kann. Man hätte es eigentlich aus dem Verhalten des Lichtes erschließen können. Daß die Lichtstärke sich nach dem gleichen Gesetz abschwächt, wenn wir uns von der Lichtquelle entfernen, wußte man nämlich schon vor Newton. Es lag nahe, daß auch andere Kräfte wie der Magnetismus und die Elektrizität dem Newtonschen Gesetze gehorchen. Diese Vermutung erwies sich als richtig. Weite Gebiete der Er[Pg 21]kenntnis wurden so durch ein Gesetz verbunden, und der Name Weltgesetz gewann seine volle Berechtigung.

Mit dem Ausspruch des Gesetzes und dem Nachweis seiner Richtigkeit für einen bestimmten Fall war es jedoch noch nicht getan. Newton erwuchs die Aufgabe, die Übereinstimmung möglichst aller astronomischen Erscheinungen mit seinem Gesetze nachzuweisen. Der Fall lag für ihn ähnlich wie für Koppernikus. In dieser Anpassung der Vorstellungen an die Tatsachen liegt die Hauptaufgabe aller Forschung großen Stils. So sehen wir auch Newton jahrelang beschäftigt, das Weltsystem einer ähnlichen großen Revision zu unterziehen, wie es vor ihm Koppernikus getan hatte. Zunächst mußte bewiesen werden, daß die Gesetze Keplers im Einklang mit dem Gravitationsgesetze stehen. Newton zeigte, daß Keplers Gesetze sich daraus ableiten lassen. Dann wies er im einzelnen nach, daß die Monde gegen die Planeten und letztere gegen die Sonne gravitieren, d.h., daß ihre Bewegungen nach dem allgemeinen Gesetz der Schwere geregelt sind. Eine Erscheinung, die bis dahin keine Erklärung gefunden hatte, war die unter dem Namen der planetarischen Störung bekannte Unregelmäßigkeit in der Bewegung der Planeten. Alle Weltkörper ziehen sich gegenseitig an. Also müssen sich auch die Planeten, wenn sie einander nahe kommen, wechselseitig merklich in ihrer Bewegung beeinflussen. Diesen Vorgang bezeichnet man als planetarische Störung. Newtons Gravitationsgesetz bot zuerst eine Handhabe, sie zu erklären und zu berechnen. Die Theorie der Planetenbewegung wurde später6 in solchem Maße ausgebildet, daß man aus der Größe der Störung, die der eine Planet erleidet, den störenden Weltkörper ermitteln lernte.

Newton durchdrang aber nicht nur das System als Ganzes, er erkannte auch die bisherige Vorstellung von der Gestalt der Erde als irrig. Die Erde galt seit dem Altertum als Kugel. Auch den Neubegründern der Astronomie fiel es nicht ein, daran zu zweifeln. »Die Welt ist kugelförmig, die Erde ist kugelförmig, und die Bewegung der Himmelskörper erfolgt gleichmäßig, ununterbrochen und im Kreise,« lauten die Worte des Koppernikus. Diese Lehren wurden von Kepler berichtigt. Er war es, der das Axiom von der kreisförmigen Bewegung der Himmelskörper zerstörte. Das Axiom von der Kugelgestalt der Erde wurde erst durch Newton widerlegt.

Die Entdeckung der Erdabplattung änderte das Weltbild indes nicht wesentlich. Auch die Entdeckung neuer Planeten oder der Monde schon bekannter Planeten bedeutete jedesmal nur einen neuen Strich im Bilde, das nach und nach durch immer mehr Einzelheiten vervollständigt wurde, ohne je wieder eine solche Umgestaltung zu erleben, wie sie Koppernikus herbeigeführt hatte.

Verändern mußten sich auch die Proportionen, die für die einzelnen Glieder des Weltalls galten. Die größte derartige Veränderung wurde dadurch herbeigeführt, daß es im 18. Jahrhundert gelang, den Abstand der Erde von der Sonne mit ziemlicher Genauigkeit zu ermitteln. Daß dieser Abstand sehr groß sei, stand fest. Schon das Altertum hatte ihn auf das Vielfache der Entfernung des Mondes von der Erde geschätzt. Nach Koppernikus betrug die Entfernung der Sonne mehr als tausend Erdhalbmesser. Im 18. Jahrhundert stellte sich heraus, daß man noch sehr weit hinter der Wirklichkeit zurückgeblieben war. Der neue, nach besserer Methode und durch genauere Messungen ermittelte Wert übertraf den von Koppernikus angenommenen um das Zwanzigfache. Auf 20 Millionen Meilen bezifferte sich das aus der Beobachtung der Vorübergänge der Venus ermittelte Grundmaß der Astronomie. Mit Hilfe dieses Grundmaßes war man imstande, die bisher nur in ihrem Verhältnis bekannten Abstände der Planeten vom Zentralgestirn nach ihrem wahren Werte zu berechnen.

Zu einer genaueren Bestimmung der Dimensionen und der Form der Erde gesellte sich im 18. Jahrhundert die Wägung unseres Planeten.

Die Ermittlung der Abplattung und des Gewichtes der Erde sind treffliche Beispiele dafür, wie neue Wahrheiten entdeckt werden. Den Ausgangspunkt bilden meist zufällige, oft ganz unbedeutende, in ihrer Ursache nicht sofort erkennbare Beobachtungen. In dem einen Falle war es die Unregelmäßigkeit im Gange einer Uhr, in dem andern die ganz geringfügige Ablenkung des Lotes, die man bei Vermessungen in der Nähe großer Berge bemerkte. An diese Beobachtungen knüpfte das Denken an. Man fragte sich, ob und unter welchen besonderen Annahmen die Beobachtung aus der bestehenden Theorie, in den vorliegenden Fällen aus Newtons Gravitationstheorie, erklärt werden könne. An diese Überlegung schlossen sich neue, nicht mehr zufällige, sondern absichtlich angestellte Beobachtungen, die in möglichst scharfen Messungen[Pg 23] bestanden und ein bestimmtes Ziel im Auge hatten. Da in den erwähnten Fällen das Ergebnis der Messungen und die Theorie im Einklang standen, so bestätigten sie sich gegenseitig.

Eine Erweiterung, wie sie seitdem kaum wieder stattgefunden hat, erfuhr das von Koppernikus, Kepler und Newton geschaffene Weltbild durch Herschel. Daß Herschel, der seit dem Altertum geheiligten Siebenzahl der Wandelsterne (Sonne, Mond, Merkur, Venus, Mars, Jupiter, Saturn) einen neuen, außerhalb des Saturn umlaufenden Planeten, den Uranus hinzufügte, daß er neue Monde entdeckte, die Rotationsbewegung am Saturn nachwies, war eigentlich schon Verdienst genug. Seine eigentliche Bedeutung liegt aber darin, daß er die Astronomie der Fixsterne begründete oder, wie Humboldt sich einst ausdrückte, daß er das Senkblei in die Tiefen des Himmels warf.

Herschel erkannte, daß die Milchstraße ein linsenförmiger, aus Millionen Sonnen zusammengefügter Sternhaufen ist, und daß die Sonne mit ihren Planeten sich etwa in der Mitte dieser Welt von Welten befindet. Lichtwölkchen, die das stärkste Fernrohr nicht in Sterne auflöst, führten Herschel zu weiteren Folgerungen. Er entdeckte solche Wölkchen zu Tausenden und sah in ihnen die Urmaterie, aus der sich neue Sternsysteme bilden. In den mannigfachen Erscheinungen, die uns der Himmel gegenwärtig darbietet, vermochte Herschel sämtliche Stufen des Weltbildungsprozesses nachzuweisen.

Die Vorstellung von dem Werden der Welt aus einem feinverteilten Urstoff hat auch Kant zu Spekulationen angeregt. Sie gipfelten darin, daß unsere irdische Materie und der Stoff der Sonne, der Planeten, ja der fernsten Weltkörper der gleiche ist, weil sie aus einer einzigen Urmaterie hervorgegangen seien.

Das Problem der Materie hat seit den ältesten Zeiten die Philosophen und die Naturforscher beschäftigt. Auch für das praktische Leben waren die stofflichen Eigenschaften und Umwandlungen von der größten Wichtigkeit. Aus den Erfahrungen der gewerblichen Praxis und den Bemühungen der Goldkocher, die den Stein der Weisen suchten, erwuchs schließlich seit der Mitte des 17. Jahrhunderts die wissenschaftliche Chemie. Man gelangte zu der Erkenntnis, daß sich die Unzahl von Stoffen, die uns im Reiche des Organischen und des Unorganischen begegnen, auf wenige Grundstoffe oder Elemente zurückführen lassen. Als solche erkannte man die Metalle, Schwefel,[Pg 24] Phosphor und verschiedene Gase. Die Trennung dieser Elemente und ihre Vereinigung: das war es, worauf der schier unbegrenzte Wechsel aller stofflichen Veränderungen sich zurückführen ließ. Waren diese Vorgänge kosmische oder waren sie auf die irdische Sphäre beschränkt, und war etwa die Welt im weiteren Sinne, das Über- oder Außerirdische, wie die Alten glaubten, aus einem besonderen Stoffe gebildet?

Zunächst erschien die Frage nach dem Wesen des außerirdischen Stoffes als eine ganz müßige. Man glaubte, daß man von der eigentlichen Beschaffenheit der Weltkörper nie etwas anderes wissen könne, als daß es sich um gravitierende Materie handele. Das wurde anders, als man sich gegen das Ende des 18. Jahrhunderts der Erforschung der Meteorite zuwandte. Daß diese kosmischen Ursprungs sind, wurde als sicher nachgewiesen. Chemie und Astronomie traten von nun an in engste Fühlung. Die Chemie war zu Anfang des 19. Jahrhunderts weit genug entwickelt, um eine Analyse des Meteoreisens und der Meteorite vorzunehmen. Sie ergab, daß neben dem Eisen auch Nickel, Kobalt und Kupfer an ihrer Zusammensetzung teilnehmen. Die steinigen Meteorite ließen außerdem noch Phosphor, Kohlenstoff, Zinn, Magnesium und viele andere den Chemikern bekannte Elemente als Bestandteile erkennen. Fast noch wichtiger als dies positive war das negative Ergebnis dieser Untersuchung. In den Meteoriten fand man kein Element, das nicht als einer der Baustoffe der Erde längst bekannt gewesen wäre. Die kosmische Materie – das war das Allgemeinergebnis dieser Untersuchung – unterscheidet sich also in keiner Weise von der irdischen. Die Stoffe, aus denen sich Welten, ja wahrscheinlich die Welt als Ganzes, zusammensetzen, stimmen mit der irdischen Materie überein.

Freilich, es waren sozusagen nur Brocken des Weltenstoffs, die in den Meteoriten der Untersuchung zugrunde lagen. Vielleicht waren es Trümmer früherer Weltkörper. An die Möglichkeit, die letzteren selbst auf ihre chemische Zusammensetzung zu prüfen, dachte zunächst noch niemand. Erst um die Mitte des 19. Jahrhunderts wurde durch die Fortschritte der Physik auch dies Problem gelöst7.

Wir sahen wie die Astronomie, die wir wohl als die älteste von allen Naturwissenschaften ansprechen können, zunächst die[Pg 25] Mathematik, dann die Physik und endlich die Chemie in ihre Dienste nahm, und wie jede Erweiterung der chemisch-physikalischen Forschung auch der Astronomie neue Methoden, neue Entdeckungen und Vorstellungen zuführte. Nur das Reich des Organischen machte bis in die neuere Zeit hinein eine Ausnahme. Es erschien als eine Welt für sich, als etwas, das vielleicht nur unseren Planeten schmückt, und sich daher nicht in die Kette des kosmischen Geschehens eingliedern läßt. Es mußte erst eine neue gewaltige Umgestaltung und Erweiterung der gesamten naturwissenschaftlichen Anschauungen eintreten, um alles Geschehen, das kosmische und das irdische, das anorganische und das organische, als etwas Einheitliches und Zusammenhängendes aufzufassen. Diese Umwälzung des naturwissenschaftlichen Denkens, die uns im vorliegenden Bande besonders beschäftigen wird, erfolgte um die Mitte des 19. Jahrhunderts. Sie bestand in der Aufstellung des Energieprinzips und in der scharfen Erfassung des Entwicklungsgedankens. Wir stehen noch heute inmitten des Ringens, das an der Hand dieser beiden Prinzipien zu immer größerer Klarheit führen wird.

Einer einheitlichen Auffassung der Naturerscheinungen stand zunächst die herrschende Vorstellung von den Imponderabilien im Wege, die als Licht- und Wärmestoff als elektrisches und magnetisches Fluidum, als Phlogiston und Lebensgeister einen ganz ungenügenden Ersatz für den heutigen Kraftbegriff bildeten. In manchen Fällen glaubte man sogar, ohne die Annahme übernatürlicher Einflüsse nicht auskommen zu können. Selbst Newton war noch der Ansicht, daß nur durch derartige Einflüsse die Stabilität des Planetensystems aufrecht erhalten werde. Und erst Laplace hat dargetan, daß eine Stabilität trotz aller Änderungen, welche die Bahnelemente der Planeten erleiden, gesichert erscheint.

Erst gegen das Ende des 18. und während der ersten Hälfte des 19. Jahrhunderts wurden die erwähnten mystischen Vorstellungen überwunden. Ermöglicht wurde dies dadurch, daß jene von der Philosophie schon früh gehegte Auffassung vom Wesen der Materie, die wir die atomistische nennen, durch Dalton auf den Rang einer naturwissenschaftlichen Theorie erhoben wurde. Jetzt erst konnte die mechanische Erklärungsweise auf die chemischen Vorgänge ausgedehnt werden. Unter dem Einfluß der atomistischen Auffassung waren auch die ersten Ansätze der mechanischen Wärmetheorie zustande gekommen. Ferner hatten Young und[Pg 26] Fresnel die Lichterscheinungen unter der Annahme eines gleichfalls aus getrennten Teilchen bestehenden Weltäthers erklärt.

Es ist zunächst zu zeigen, wie durch die Entdeckung neuer Tatsachen und Beziehungen auf allen Gebieten, sowie durch das Hinwegräumen veralteter Vorstellungsgebilde eine auf dem Energieprinzip beruhende Naturauffassung vorbereitet und geschaffen wurde. Wie sich auf diesem Fundament das Weltbild bis auf den heutigen Tag gestaltet hat, und welche Wirkungen von den Naturwissenschaften ausgingen, das zu schildern wird die Aufgabe der letzten Abschnitte dieses Werkes sein.

Wir haben in dem vorigen einleitenden Abschnitt in großen Zügen die Entstehung des Weltbildes von den ältesten Beobachtungen bis zur Begründung der Fixsternastronomie durch Herschel verfolgt.

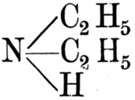

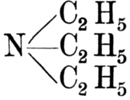

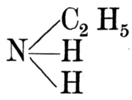

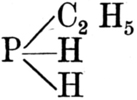

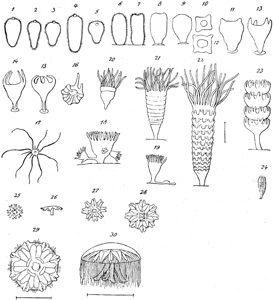

Trotz der Vollendung, welche die Gravitationsmechanik durch Laplace erfahren hatte, bereitete der von Herschel aufgefundene Uranus den Astronomen große Schwierigkeiten. Nachdem für diesen Planeten Beobachtungen vorlagen, die sich über 40 Jahre erstreckten, war man zur Herstellung von Tafeln8 geschritten. Bald nach der Entdeckung des Uranus hatte sich ergeben, daß einzelne Stellungen dieses Planeten schon von älteren Astronomen9 im Verlauf des 18. Jahrhunderts vermerkt worden waren; nur hatte man diese Beobachtungen auf einen Fixstern 6. Größe, nicht aber auf einen unserem Sonnensystem angehörenden Weltkörper bezogen. Jene älteren Beobachtungen ließen sich jedoch nicht mit den neueren zu brauchbaren Tafeln vereinigen. Man verwarf daher die ersteren als ungenau, obgleich man damit den betreffenden Beobachtern gewaltige Fehler zur Last legte.